SESGO EN SISTEMAS DE INTELIGENCIA ARTIFICIAL

Hace un tiempo escuché el termino Discriminación Algorítmica y no entendía como un algoritmo podía discriminar. Leyendo un poco más sobre el tema encontré que esta situación se está presentando en los Sistemas Automatizados de Toma de Decisiones controlados por algoritmos (ADMS, por sus iniciales en inglés) que día a día ocupan un lugar importante en diferentes aspectos de nuestra vida siendo un apoyo en la toma de decisiones en sectores como el de la salud, la construcción, el financiero, o facilitando actividades diarias con elementos como el reconocimiento de voz.

Estos algoritmos son entrenados a partir de conjuntos de datos para que basados en la información puedan tomar decisiones. Si, una maravilla, de eso no cabe duda, pero con o sin intención estos datos pueden tener sesgos contra ciertos grupos principalmente por su género, aunque también por su raza, cultura o condición socioeconómica. Estos sesgos pueden llegar a excluir o afectar de forma negativa a las mujeres o personas de identidad no binaria dando lugar al concepto de Discriminación Algorítmica de Género. En esta publicación veremos qué es, por qué se presenta y qué se podría hacer para mitigarlo.

Así se incorporan los sesgos

Los algoritmos de aprendizaje automático procesan grandes cantidades de datos llamados Conjuntos de Datos y son entrenados con ellos para encontrar patrones y basados en esta información puedan hacer predicciones. Dichos Conjuntos se obtienen con la previa recopilación y clasificación de datos.

En este proceso, hay dos puntos clave donde se pueden incorporar los sesgos, en la creación de los conjuntos de datos y al hacer el entrenamiento.

En la recolección de los datos o cuando se etiquetan y clasifican pueden incluirse los sesgos de varias formas. Una forma es no contar con muestras diversas y representativas en la recolección de los datos, un ejemplo de esto es expuesto por Digital Future Society[1] donde muestran que según el Informe Mobile Gender Gap Report 2021[2], las mujeres tienen 7% menos probabilidad que los hombres de tener celular y un 15% menos probabilidad de usar internet móvil. Siendo así, al tener menor acceso a internet, las mujeres generan menos cantidad de datos y cualquier conjunto de datos no estará representando de forma igualitaria a las mujeres y así cualquier toma de decisiones a partir de ellos estará beneficiando y satisfaciendo las necesidades de los hombres y no de las mujeres.

En el entrenamiento de los algoritmos también se introducen los sesgos porque allí es donde se determinan los conjuntos de datos a usar, las variables y reglas que aprenderán los algoritmos. Al no tener conciencia sobre la posibilidad del sesgo en los datos, los científicos de datos y demás profesionales en Inteligencia Artificial (IA) que intervienen en el desarrollo, utilizaran data ya sesgada. Por otra parte como la presencia de las mujeres en IA es muy baja, al momento de construir las reglas y elegir las variables, al no tener una representación significativa, no se está pensando en las necesidades propias de las mujeres y menos aún de géneros no binarios.

El impacto de los datos sesgados

En el artículo de Discriminación algorítmica de Digital Future Society se analiza un artículo de Stanford Social Innovation Review [3] que ofrece algunos ejemplos del sesgo de género en diversos sectores y el impacto negativo que tienen y que a simple vista pueden pasar inadvertidos:

En la salud, el cuerpo masculino ha sido el estándar para los ensayos médicos ya que el cuerpo femenino se considera más complejo y variable. Por lo tanto, los conjuntos de datos asociados a estas pruebas realmente no representan a la mujer. Por ejemplo, los sistemas de IA que son apoyo para detectar el cáncer de piel, tienen dificultades para identificar el melanoma en personas afrodescendientes, sumando de esta forma a la falta de representación de la mujer, la posibilidad de poner en mayor riesgo a la mujer afrodescendiente.

Los sistemas de bienestar que ofrecen beneficios a personas vulnerables pueden asignar recursos y oportunidades de forma injusta a mujeres por datos segados, como lo explica Digital Future Society en su Informe Hacia la igualdad de género en el estado de bienestar digital [4]. La falta de datos de género reduce la posibilidad de apoyar a las mujeres haciéndolas invisibles. La presencia de datos cuantitativos sin un contexto no refleja la complejidad de las situaciones que experimentan las mujeres detrás de la violencia en el hogar o el tiempo que deben dedicar como cuidadoras y que les impide acceder a trabajos de tiempo completo.

Es común encontrar conjuntos de datos que no estén desagregados por sexo y género o con una representación excesiva o escasa, por lo tanto ocultan diferencias entre personas y necesidades propias de un género. Un ejemplo de esto son los datos urbanos que generalmente no rastrean datos por género por lo que los programas de infraestructura no tienen en cuenta las necesidades de las mujeres.

Ahora bien, tener datos representativos no es una garantía ya que pueden tener prejuicios incorporados. Un ejemplo de esto son los sistemas IA para crédito de consumo. Históricamente, los procesos determinaban la solvencia económica de acuerdo al estado civil y el género, y aunque esta práctica cambió, esto hizo que las mujeres tuvieran un historial financiero menos formal y que accedieran menos a créditos. Entonces, con datos ya discriminatorios, los algoritmos aprenden con ellos y detectan como patrón que las mujeres tienen límite crediticio más bajo que los hombres y continúan manteniendo la brecha de género ya establecida.

Otro ejemplo de sesgo por datos con prejuicios incorporados son los algoritmos de reclutamiento para empleo que perpetúan prácticas de contratación discriminatoria ya que sus patrones descartan la hoja de vida (CV) de mujeres en cargos que han sido ocupados generalmente por hombres a pesar que sus perfiles sean similares.

En la recolección de datos demográficos se evidencia como una clasificación simplista del género de la población en mujeres y hombres sin tener en cuenta otras identidades de género reduce el potencial de la IA para visibilizar las identidades en diferentes análisis.

Los algoritmos de reconocimiento facial son un ejemplo de lo que sucede cuando los conjuntos de datos no tienen muestras diversas y representativas. En ellos se identificó que por esta falta de diversidad, el reconocimiento facial tenía más errores detectando el rostro de mujeres que de hombres, así mismo también presentaba una tasa de error más baja detectando hombres de piel más clara. Aquí además de un sesgo racial por lo poco representativas de las muestras, nuevamente el uso binario de género también puede ofrecer una visión inexacta de género.

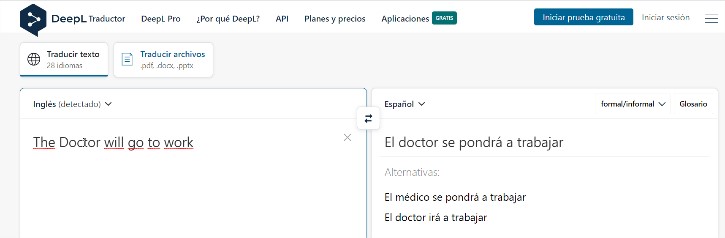

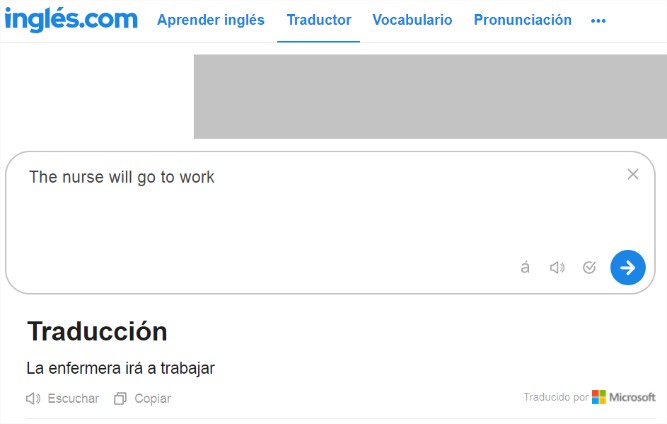

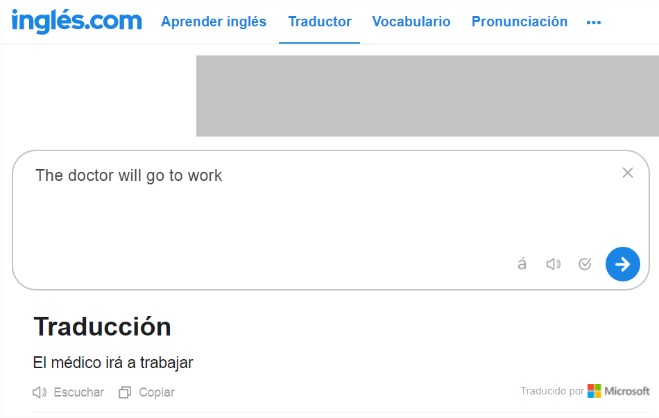

Un último ejemplo son los traductores de inglés a español que aprenden de texto en línea donde términos de género neutro en inglés como Doctor y Nurse ha sido traducido asignando género que refuerza los estereotipos de Médicos y Enfermeras. A continuación se muestra la traducción hecha con los traductores de DeepL.com e Ingles.com donde se evidencia este sesgo:

Tomado de: https://www.deepl.com/es/translator

Tomado de: https://www.ingles.com/traductor

Posibles soluciones

A continuación se presentan algunos puntos que pueden marcar la diferencia. Estas propuestas son tomadas de cuatro principios básicos recopilados del informe Sesgo de Género en los datos: hacia la igualdad de género en el bienestar digital y lo que pueden hacer los líderes de cambio social según el artículo de Stanford:

• Usar conjuntos de datos de género relevantes. En Estados Unidos para el 2019 se contó con datos normalizados sobre mortalidad materna de los 50 estado revelando la desigualdad entre mujeres blancas y afrodescendientes donde estas últimas mueren 2.5 veces más a menudo. Esto es un ejemplo de cómo tener datos de género y analizar esa información según el caso teniendo en cuenta otros aspectos como raza, condición socioeconómica o cultura puede marcar la diferencia e impactar positivamente a la población.

• Contextualizar los datos dentro de realidades culturales y socioeconómicas más amplias

• Capacitar a los profesionales que trabajan con IA sobre cómo evitar los sesgos, también alfabetizar en IA a expertos en género.

• Priorizar la equidad de género como objetivo principal de los sistemas de IA

• Incorporar la diversidad de género, la equidad y la inclusión entre los equipos de desarrollo de IA

• Incluir mujeres, otras identidades de género y grupos históricamente discriminados en el proceso de diseño y retroalimentación. Se cree erradamente que lo relacionado con el desarrollo de Sistemas IA es netamente técnico, aquí es donde el co-diseño es fundamental.

• Evaluar el conjunto de datos que se va a utilizar para detectar una baja representación de las diferentes identidades y la presencia de desigualdad de género.

• Evaluar el impacto de género en los modelos de toma de decisiones.

CITIC recomienda prestar especial atención a la recolección de datos para que según sea el objetivo del estudio, se dé una perspectiva de género que de valor al conjunto de datos. También es importante hacer una evaluación del impacto de género que puede tener el conjunto de datos a utilizar.

La Inteligencia Artificial pone la tecnología al servicio de la comunidad, facilitando procesos que sin ella tomarían mucho tiempo y se busca que apoye la toma de decisiones de la forma más objetiva posible. Es importante por ello que conociéndose la existencia de los sesgos acá expuestos se les de la importancia requerida y se adopten medidas para subsanarlo y llevar equidad de género a sus procesos. Los sesgos incorporados en los sistemas reflejan los prejuicios que tenemos como sociedad, y que al igual que sucede en los algoritmos, están presentes y no los vemos.

¿Necesita asesoría sobre la evaluación de impacto de género en sus datos? En CITIC lo podemos ayudar, ¡contáctenos!

[1] Digital Future Society. (2022). Discriminación algorítmica de género: ¿de dónde viene, cuál es el impacto y cómo podemos abordarlo? https://digitalfuturesociety.com/es/algorithmic-gender-discrimination-where-does-it-come-from-what-is-the-impact-and-how-can-we-tackle-it/[2] Carboni, Isabelle. (2021). The Mobile Gender Gap Report 2021. GSMA Connected Women. https://www.gsma.com/r/wp-content/uploads/2021/06/The-Mobile-Gender-Gap-Report-2021.pdf

[3] Smith, G., & Rustagi, I. (2021). When Good Algorithms Go Sexist: Why and How to Advance AI Gender Equity. Stanford Social Innovation Review. https://doi.org/10.48558/A179-B138

[4] Digital Future Society. (2022). Hacia la igualdad de género en el estado de bienestar digital. https://digitalfuturesociety.com/app/uploads/sites/9/2020/09/Hacia_igualdad_g%C3%A9nero_en_estado_bienestar_digital-1.pdf